Le son, une fois capté par l’oreille, est transformé au niveau de la cochlée en signal électrique, lequel se propage le long du système nerveux pour être traité par le cortex auditif. Comment ce message de nature physique est-il décodé par les neurones ? Quelle est la traduction biologique d’un mot ? C’est à ces questions qu’ont voulu répondre les neuroscientifiques de deux universités californiennes, à Berkeley et San Francisco. Pour cela, ils ont mesuré l’activité électrique d’une aire particulière du cortex, le gyrus temporal supérieur, qui fait partie de l’aire de Wernicke, classiquement considérée comme l’aire de la compréhension du langage. Par un traitement informatique des ondes cérébrales, ils ont réussi à “recréer”, au moins en partie, le son recueilli par l’oreille, ouvrant peut-être la voix à un traducteur de nos voix intérieures.

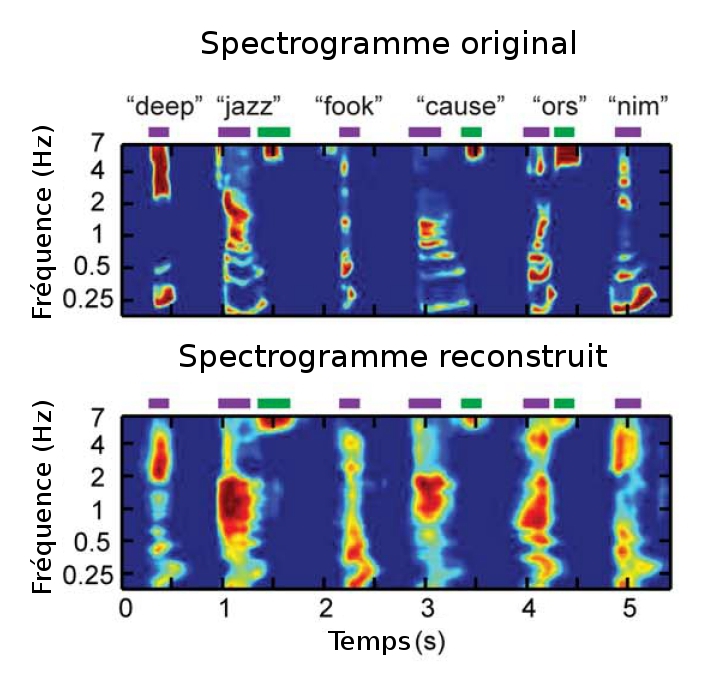

À partir de l’activité électrique mesurée en surface de la zone cérébrale d’intérêt suite à l’audition d’un mot simple, les physiciens ont appliqué différents modèles numériques dans le but de reconstituer le signal sonore initial. Ce traitement mathématique calcule ainsi un spectrogramme, c’est-à-dire un son : ce diagramme traduit en effet les variations temporelles de l’amplitude sonore sur l’ensemble des fréquences audibles, et peut ainsi être comparé au son entendu pour évaluer la justesse du calcul effectué. Plusieurs modèles de reconstruction sont utilisés : un premier modèle linéaire repose sur une réponse proportionnelle des neurones au spectrogramme du son entendu, alors qu’un second modèle plus complexe, dit non-linéaire, associe plutôt l’activité neuronale à la modulation du son. Cette caractéristique du son traduit plus fidèlement que le spectrogramme les différentes variations du spectre, comme les formants ou les successions de syllabes, caractéristiques de la parole. Le second modèle, plus sensible aux variations rapides de la parole, aboutit ainsi à des spectrogrammes plus fidèles, le son reconstruit étant plus souvent reconnu. Vous pouvez vous faire une idée de la qualité de la reconstruction sur quelques exemples disponibles à l’écoute ici.

Le chant des neurones

Selon les auteurs, ces deux modèles correspondraient à deux sous-populations de neurones, identifiées dans le cortex auditif primaire de primates non humains, lesquelles prendraient chacune en charge des fluctuations plus ou moins rapides du stimulus sonore, utilisant pour cela des stratégies différentes de codage de l’information auditive. Le son reconstruit par le modèle non linéaire, s’il est plus précis et peut être reconnu, reste néanmoins assez éloigné du son initial ; les physiciens pensent pouvoir améliorer la sensibilité du système en perfectionnant la qualité de l’enregistrement des ondes cérébrales.

Peut-être pourra-t-on alors atteindre la précision atteinte par d’autres neuroscientifiques de l’université de Berkeley dans la reconnaissance d’images vues en analysant l’activité du système visuel primaire dans une étude publiée en 2009 (d’autres exemples sont détaillés ici). Brian Pasley, l’un des auteurs de l’étude, se prend à rêver : “Il semble que la perception et l’imagination sont des phénomènes assez similaires au niveau du cerveau. Si nous pouvons comprendre la relation entre l’enregistrement cérébral et le son, nous pourrions synthétiser les sons qu’une personne imagine, ou plus simplement les transcrire à l’écrit par une interface.” Ainsi, nous pourrions traduire en sons nos pensées intimes, qui restent du domaine du dialogue intérieur, et réaliser le rêve de tous les télépathes…

Article publié pour la revue Audiology infos.

Source : B. Pasley et al., Reconstructing Speech from Human Auditory Cortex, PLoS Biology, 31 janvier 2012.

Crédit photo : elkit (CC BY-NC-SA 2.0).